A l’occasion du salon Mobile World Congress 2019 de Barcelone, du 25 au 28 février, le constructeur automobile BMW présente pour la première fois l’interaction naturelle et multi-mode entre le véhicule et le conducteur.

Combiner la voix, le regard et les gestes

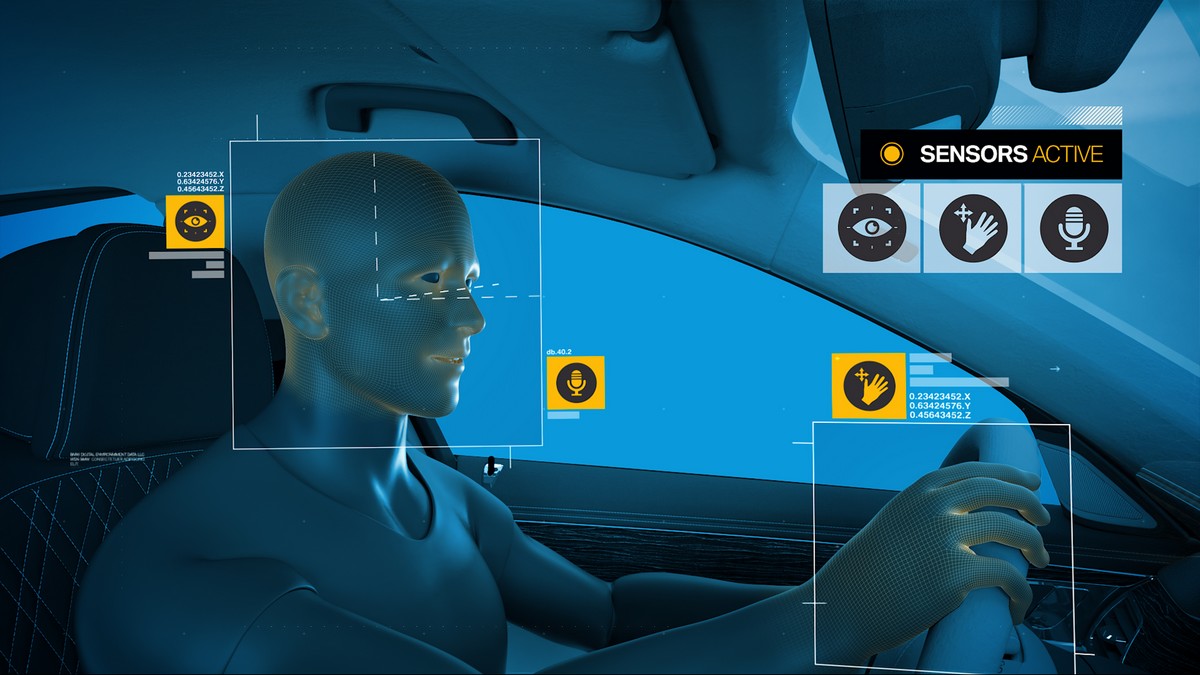

Le système BMW Natural Interaction combine la commande vocale avec un contrôle gestuel et une reconnaissance du regard afin de permettre un fonctionnement multimodal. Les premières fonctions de BMW Natural Interaction seront disponibles dans la BMW iNEXT à partir de 2021.

Les commandes vocales, les gestes et la direction du regard sont détectés par le véhicule

Les fonctions du véhicule peuvent alors être lancées de différentes manières. Le conducteur décide comment il souhaite interagir. S’il est en train de parler, il choisira probablement le geste et le contrôle du regard. Si ses yeux sont rivés sur la route, il comptera sur la parole et les gestes. Ainsi, par exemple, les fenêtres de la voiture ou le toit ouvrant peuvent être ouverts ou fermés, les bouches d’aération ajustées ou une sélection effectuée sur l’écran de contrôle. Si le conducteur souhaite en savoir plus sur les fonctions du véhicule, il peut également pointer sur des boutons et demander leur usage.

La voiture prend en compte son environnement

La voiture prend en compte son environnement

L’espace pris en compte ne se limite pas à l’intérieur du véhicule. Les occupants pourront interagir selon leur environnement direct, tels que des bâtiments ou des places de stationnement. Même les requêtes complexes pourront être traitées en pointant un doigt et en émettant une commande vocale : « c’est quoi ce bâtiment ? Combien de temps cette entreprise est-elle ouverte ? Comment s’appelle ce restaurant ? Est-ce que je peux me garer ici et combien ça coûte ? »

Une amélioration de technologies introduites en 2015

Les capteurs ont été améliorés. À l’aide d’un signal lumineux infrarouge, la caméra gestuelle peut désormais capturer les mouvements de la main et du doigt en trois dimensions dans l’ensemble de l’environnement d’exploitation du conducteur et déterminer un vecteur directionnel précis. Par exemple, pointer un index sur l’écran de contrôle et énoncer une commande lance l’opération souhaitée sans toucher l’écran. La caméra haute définition intégrée au tableau de bord enregistre également la direction de la tête et des yeux.

Un usage de l’intelligence artificielle

La technologie de caméra intégrée évalue les images et les utilise pour calculer les données vectorielles requises, qui sont ensuite traitées dans le véhicule. Pour interpréter les instructions vocales, en plus des gestes, les informations transmises par le conducteur au véhicule sont combinées et évaluées à l’aide de l’intelligence artificielle. L’algorithme responsable de l’interprétation des données dans la voiture est affiné en permanence grâce à l’apprentissage automatique et à l’évaluation de différents scénarios de fonctionnement.

Le conducteur pourra également pointer du doigt des objets se trouvant dans son champ de vision et donner des commandes vocales, telles que demander des informations sur les heures d’ouverture d’un restaurant ou les évaluations des clients, ou réserver une table. En connectant des services numériques, il sera possible d’élargir la portée de l’interaction à l’avenir. Par exemple, lorsque le conducteur trouve une place de parking, il saura s’il est autorisé à s’y garer et quel en est le coût.